প্রকাশ: মঙ্গলবার, ২৯ জুলাই, ২০২৫, ৬:২৩ পিএম

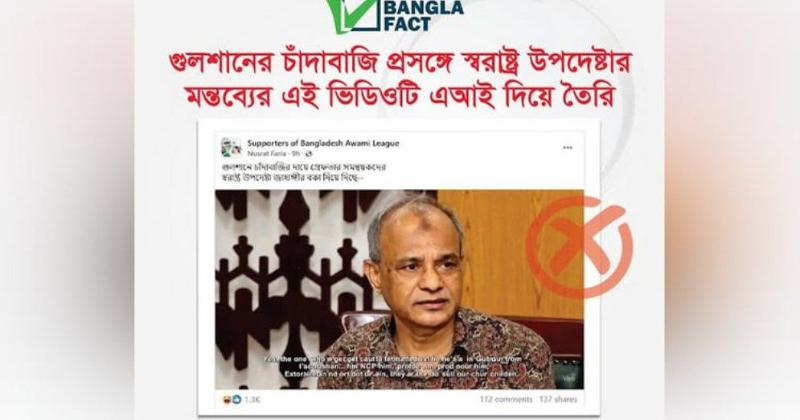

কৃত্রিম বুদ্ধিমত্তা (এআই) ব্যবহার করে স্বরাষ্ট্র উপদেষ্টার বক্তব্য দাবিতে একটি ভিডিও ছড়িয়ে বিভ্রান্তি সৃষ্টির অপচেষ্টা শনাক্ত করেছে প্রেস ইনস্টিটিউট বাংলাদেশ (পিআইবি)-এর ফ্যাক্টচেক ও মিডিয়া রিসার্চ টিম ‘বাংলাফ্যাক্ট’।

বাংলাফ্যাক্ট অনুসন্ধান টিম জানায়, কৃত্রিম বুদ্ধিমত্তা বা এআইয়ের সাহায্যে তৈরি একটি ভিডিওকে গুলশানে চাঁদাবাজির ঘটনায় স্বরাষ্ট্র উপদেষ্টার মন্তব্য হিসেবে দাবি করে সামাজিক যোগাযোগ মাধ্যমে ছড়ানো হয়েছে; যা সম্পূর্ণ মিথ্যা।

বাংলাফ্যাক্ট আরও জানায়, গুলশানের চাঁদাবাজি প্রসঙ্গে স্বরাষ্ট্র উপদেষ্টার মন্তব্যের যে ভিডিওটি ছড়ানো হয়েছে, সেটি এআই দিয়ে তৈরি।

এর আগে, গত ২৬ জুলাই রাজধানীর গুলশানে গণতান্ত্রিক ছাত্র সংসদ ও বৈষম্যবিরোধী ছাত্র আন্দোলনের সদস্য পরিচয়ে আওয়ামী লীগের সংরক্ষিত আসনের সাবেক সংসদ সদস্য শাম্মী আহমেদের বাসায় ঢুকে ৫০ লাখ টাকা চাঁদা দাবির অভিযোগে পুলিশ পাঁচজনকে আটক করে। পরে উভয় সংগঠন থেকে অভিযুক্তদের স্থায়ী বহিষ্কারের বিষয়টি গণমাধ্যমে প্রকাশিত হয়।

এই ঘটনার পর একটি মহল অন্তর্বর্তী সরকারের স্বরাষ্ট্র উপদেষ্টা লেফটেন্যান্ট জেনারেল (অব.) মো. জাহাঙ্গীর আলম চৌধুরীর নামে একটি ভুয়া ভিডিও প্রচার করে। এআই দিয়ে বানানো সেই ভুয়া ভিডিওতে বলতে শোনা যায়, ‘চাঁদাবাজ হোক বা যাই হোক, ওরা তো আমাদেরই সন্তান। হ্যাঁ, গুলশানে যে ধরা পড়েছে সে আমাদের এনসিপির নেতা। আমি বকে দিয়েছি, বলেছে আর করবে না।’

বাংলাফ্যাক্টের যাচাইয়ে উঠে আসে, এই বক্তব্যের কোনো সত্যতা নেই এবং সংশ্লিষ্ট কোনো বিশ্বস্ত সূত্রেও এমন মন্তব্যের প্রমাণ পাওয়া যায়নি। প্রকৃতপক্ষে ভিডিওটি কৃত্রিমভাবে তৈরি এবং এতে ডানপাশের নিচে ‘ভিও’ লেখা দেখা যায়। জানা যায়, এটি হলো গুগলের কৃত্রিম বুদ্ধিমত্তা ভিত্তিক একটি টুল, যার মাধ্যমে লেখা থেকে শব্দসহ ভিডিও তৈরি করা সম্ভব। ভিডিওটিতে ইংরেজি সাবটাইটেলে বাক্য গঠন, ব্যাকরণ এবং বানানে একাধিক ভুল রয়েছে, যা ভিডিওটির অসত্যতা প্রমাণ করে।

উল্লেখ্য, বাংলাদেশে চলমান গুজব, ভুয়া খবর ও অপতথ্য প্রতিরোধ এবং জনগণের কাছে সঠিক তথ্য পৌঁছে দিতে নিয়মিত কাজ করে যাচ্ছে বাংলাফ্যাক্ট। -বাসস